前言

写好网站robots,有助于网页的的快速收录,其次能节省网站的资源。在网站上线之前,就规划好我们要重点收录的页面,对应写好robots。

目录

01.前提:规划栏目

02.robots的针对性

03.实操演示

最后的话

01 前提:规划栏目

在网站上线之前,我们要进行关键词分析,确定我们的主词,短语词,长尾词。

然后建立词库规划栏目开始布局这些词。布局好以后,下一步就是撰写网站抓爬协议robots。

但在书写robots之前,必须有明确的目标。这个目标就是栏目规划。当我们规划好栏目以后,自然就明白,哪些栏目是要蜘蛛抓取的,哪些是不要蜘蛛抓取的。

02 robots的针对性

写robots必须针对性书写,不能乱写。乱写会给站内SEO优化带来一些小麻烦,得不偿失。

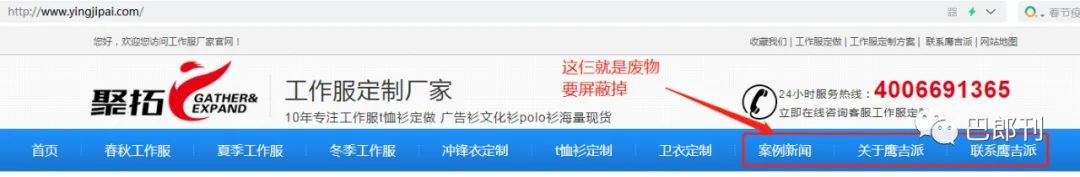

那么如何针对性的书写robots呢?我们以一个传统企业的官网:【鹰吉派】举例。

鹰吉派官网

这个网站首页中布局了9个关键词,前6个都与业务相关没有任何问题。后面3个就有问题了,问题出在哪里呢?我们看它的网站地图。这样写在一定程度上影响了排名。并且存在2个问题

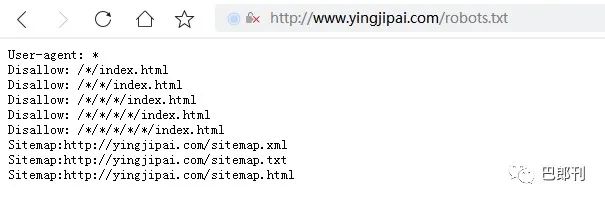

鹰吉派官网robots.txt

抓取对象多会非常耗费蜘蛛与服务器资源

1.抓取对象太多,且权重易分散

2.没有明确抓取的重心

那么如何书写呢?我们第03节细讲。

要明确抓取重心

03 实操演示

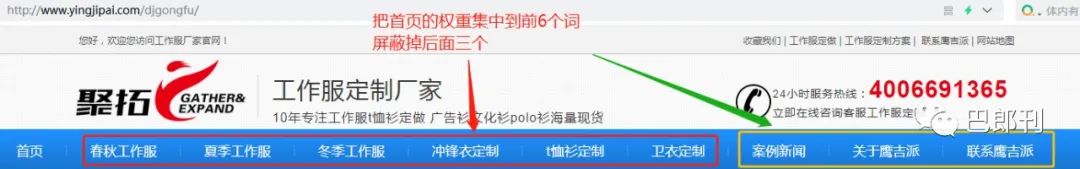

1、减少抓取对象

前面讲到栏目规划,这里我们看到了9个栏目,最后的三个栏目是废物,必须要屏蔽掉。让蜘蛛明确抓取前6个栏目即可,正确书写如下。

屏蔽后面三个栏目

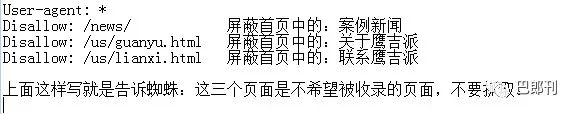

2、没有明确收录的重心

蜘蛛抓取网站数据有一个特殊爱好。它的抓取方式是:从左往右,从上到下。

因此把你最想收录的页面给它做一个抓取提示,它看到你的提示,它就有了大致的抓取方向,抓起来就更高效,更快捷。

提示让它抓这6个页面

最后修改robots如下,检查完毕上传网站根目录即可。

修改后的官网robots.txt

上图中,我明确写出了6个页面是给蜘蛛6个建议。但在这里我建议你根据自己业务的实际情况只写一个。

这个页面可以是网站中最核心的那个页面,它可以是单页面,也可以是栏目页,也可以是聚合页。具体请以实际情况为主,不要生搬硬套。

最后的话

网站robots与站内SEO优化的关系比较特别。它并不直接影响SEO优化,但会间接产生副作用。

在网站上线以前,就要处理好它与站内SEO之间的关系。书写规范是必须的,一定要写好。

由于互联网数据的缓存关系,robots上传以后的生效期是1-3天左右。并不是立刻生效。

在1-3天内,蜘蛛不会按照robots协议进行抓取。当1-3天缓存更新以后,蜘蛛才会按照协议去抓取。

其次每个搜索引擎的生效时间各有不同,存在差异。这点请在实战中仔细观测。

做一个有趣的人,再见巴郎!

作者:巴郎刊

来源:巴郎刊(balangk)